Man kann die Erkenntnis nicht einfach beiseite wischen, dass im gegenwärtigen Kapitalismus der Modus der Produktion in technologischer Hinsicht stark auf Software basiert und dass Software Mathematik ist. Folglich lässt sich auch ein recht simpler Syllogismus anschreiben, der die Schlussfolgerung enthält, dass der heutige Modus der Produktion Mathematik ist. Mit der Mechanisierung der Mathematik (»Booles Forms of Thought«) wird die Maschine theoretisch und die Theorie maschinell – und nichts anderes heißt schließlich Algorithmisierung. Und Schaltkreise, bei denen der Strom fließt, wenn sie geschlossen sind, während der Strom unterbrochen ist, wenn sie offen sind, zeugen davon, dass der Kalkül qua Implementierung in die Computertechnik eingewandert ist. Mit Kittler lässt sich Folgendes kaum leugnen: »So unersetzlich die Hardware im allgemeinen also für Rechenleistungen und Speicherkapazitäten bleibt, so ersetzbar ist jede Hardware im einzelnen geworden.« (Kittler 2013a) Und Konstruieren bedeutet nach Kittler Maschinen der Verschaltung, die Computer heißen, unter dem Befehl Programmsteuerung aufzurufen, zu verknüpfen und auf ein Optimum hin durchzutesten. Dabei fällt das digitale Diagramm im Extremfall mit seiner eigenen Simulation zusammen. Man kann sagen, dass Computed Aided Design auf nicht-triviale Weise selbstreferenziell ist. Und in diesem Zusammenhang gilt es wieder darauf hinzuweisen, dass Informationen immer einen materiellen Träger besitzen, seien es etwa nach Brown sich bewegende Gasmoleküle, ausbreitende Schallwellen, elektromagnetische Felder, Silizium oder Festplatten oder Internetseiten. Dabei eignen sich bestimmte Arten der Information für den Kauf/Verkauf besonders gut, andere eben nicht. Und es lassen sich mit Informationen nur dann Geschäfte machen, wenn man sie knapp halten kann. Darin besteht die in philosophischen und semiotischen Theorien oft vernachlässigte materielle/ökonomische Seite der Digitalisierung. Gehen wir aber schrittweise vor.

Im Internet kommunizieren Computer über komplexe Protokolle miteinander, indem die Verbindungen durch die Ankopplung unsichtbarer Maschinen (Protokollschichten des »Open Systems Interconnection Reference Model«) an automatisierte Agenten (»Aplication Programming Interface«), sog. Anwendungs-Programmierschnittstellen, erfolgen, denen man eine gewisse Sichtbarkeit zugesteht, das jedoch auch nur eingeschränkt und unter der Kontrolle einer ganz bestimmter Syntax von Handlungen und Aussagen. (Hagen 2010a: 15f.) Entscheidend ist hier das Konzept des Referenzprotokolls, eine Sammlung von Verfahren, die die mannigfaltigen Relationen in Netzwerken regeln, und dies in einer pfadabhängigen Umwelt. Netzwerkprotokolle prozessieren mit Codes und werden über bestimmte Informationspakete transportiert. Sie kodieren auf rein formeller Basis Dokumente, um sie effektiv zu zergliedern und zu transportieren, und sie kodieren Kommunikationen, damit Geräte an verschiedenen Orten miteinander kommunizieren können. Als Effekte von mehrdimensionalen Netzwerktechnologien setzen die Protokolle, strukturierende Agenten, die als ein Set objektiver Dispositionen fungieren, Techniken einer äußerst flexiblen sozialen Kontrolle und nichthierarchischer Regulierung ein. Dies schließt daran an, dass Turing-Maschinen als Verkettungen von integrierten Schaltungen, die heute jeden nur berechenbaren Algorithmus mit extremer Geschwindigkeit prozessieren, Maschinenumgebungen problemlösender Maschinen schaffen, in die die Störungen je schon integriert sind. Und selbst algorithmische Fehler implizieren, dass Computer funktionieren, aber womöglich ganz anders als gedacht – und solange die Maschinen funktionieren, prozessieren sie eben, denn schließlich gibt es keine externe Maschine, die ad hoc beweisen könnte, dass es nicht richtig läuft.2 Das Internet lässt sich als eine Hypermaschine von Milliarden verkoppelter Computermaschinen verstehen, die als ein dynamisches Netzwerk aus Netzwerken funktioniert, das aus Knoten und Verbindungen besteht, welche heute über den gesamten Globus verteilt sind. Man geht dabei von »gerichteten Multigraphen« aus, wobei die Webseiten »Knoten« und die Links zu den Webseiten sog. »gerichtete Kanten« darstellen, die zwei Knoten jeweils in eine Richtung verbinden. (Ebd.) Und über die Links bilden sich in jedem Moment weitere kontingente Netzwerkstrukturen, die man allenfalls über Suchmaschinen und deren Algorithmen im Sinne einer signifikanten Assoziationslogik zu integrieren versucht, wobei das Netz selbst in mehrere Zentren gesplittet ist, die wiederum relativ inhomogene Strukturen mit inhomogenen Umgebungen darstellen und z. T. hermetisch gegeneinander abgeriegelt sind. Über sich selbst reflektiert das Internet also mithilfe von Suchmaschinen, die das Gedächtnis dieses spezifischen Mediums operational und immer nur potenziell herstellen, in dem sie graduelle Gewichtungen explizieren, die schlussendlich jeder Antwortliste, die ein User anfordert, implementiert wird. Somit prozessiert das Internet das Gedächtnis über die sich ständig verändernden Summen von singulären Suchoperationen, wobei eine Suche nur dann gelingt, wenn man Webpages indiziert und damit einer Bewertung zugänglich macht. (Hagen 2010b: 6) In diesem Zusammenhang hat die Netzwerkforschung längst erkannt, dass vor allem Knoten, die möglichst viele Verbindungen zu anderen Knoten besitzen, das Wachstum der Netzwerke unaufhörlich vorantreiben, wobei entsprechende Protokolle die Offenheit der sog. many-to-many-organization erlauben, weil u. a. die zugrunde liegenden Richtlinien und Mechanismen open-source basiert und zunächst indifferent gegenüber den Inhalten sind.

Die Struktur der offenen und unkontrollierten Vernetzung basiert im Internet darauf, dass das Transmission Control Protocol (TCP) und Internet Protocol (IP) die Übersendung von Daten von einem Computer auf einen anderen ermöglichen, sodass jeder Computer des Netzwerks mit jedem anderen kommunizieren kann. Das ist der Aspekt der sog. anti-hierarchischen Struktur. Schließlich befindet sich TCP/IP nicht im Besitz eines Unternehmens oder einer Institution, sondern beruht auf einer freiwilligen Übereinkunft der beteiligten Aktanten, wenngleich diese wiederum einem strukturellen Zwangsverhältnis aufsitzt: Es steht jedem Knoten des Netzwerks natürlich frei, TCP/IP nicht zu verwenden, wobei in diesem Fall die Verbindung zu anderen Computern über das Internet einfach gekappt wird. Das horizontale TCP/IP System, das Verbindungen etabliert und den Datenstrom durch diese Verbindungen ermöglicht, beinhaltet eine nicht-hierarchische Peer-to-Peer-Relation, aber das ist nur eine, die scheinbar freiheitliche Seite des Internets, denn die Protokolle generieren stets auch Formen der Kontrolle, in gewisser Weise homogenisieren sie den Content, da schlichtweg alles, was gesagt wird, in einem vorgegebenen Format gesagt werden muss, womit die User nicht die Wahl besitzen, die strikt fixierten Steuerungssysteme der Protokolle und ihre Mechanismen außer Kraft zu setzen. Das TCP/IP System steht demgemäß in Korrelation mit den Anforderungen des DNS-System, das die Netzwerkadressen an Netzwerknamen bindet und damit Knoten und Pfade des digitalen Raumes in Territorien einteilt und fixiert. Klar definierte Hierarchien werden also durch das Domain Name System (DNS) eingeführt, i. e. eine dezentralisierte Datenbank, welche die für Transaktionen notwendigen Informationen enthält, wie man eine Netzwerkadresse (IP Adresse) mit einem Netzwerknamen erfasst. An der Spitze dieser hierarchischen Struktur stehen einige wenige Root Server, die die Oberkontrolle besitzen und untergeordnete Kontrollen an niedriger gestellte Abteilungen in der Hierarchie delegieren. Nur unter Berücksichtigung dieser grundlegenden Vorschriften können Webseiten weitere Code-Umgebungen mit spezifischen Regeln und Algorithmen implementieren, womit sowohl relativ unregulierte als auch hochgradig gesicherte Bereiche entstehen (anonyme Informationsübertragung auf der einen und verschlüsseltes, personalisiertes Online-Banking auf der anderen Seite). Damit stellt die Implementierung von Protokollen eine universelle und zugleich im verborgenen arbeitende Technologie der Kontrolle als Teil eines strategischen Dispositivs im Rahmen eines neuen Machttypus der Hyperkommunikation dar, der über äußerst flexible Kräfterelationen funktioniert. Alexander Galloway schreibt hierzu: »By design, protocols such as the Internet Protocol cannot be centralized.« (Galloway 2006: 11) Gerade aber die freie Verfügbarkeit über Protokolle impliziert eine Logik der Kontrolle, die nicht mehr über Mechanismen der Ausschließung funktioniert, sondern deren Wirkungen man als modular, inklusiv und homogenisierend oder – mit einem Begriff von Foucault – als »zentrifugal« bezeichnen könnte. (Vgl. Foucault 2004a: 8) Offensichtlich haben wir es hier mit einem flexiblen Kontrolldispositiv zu tun, dem eine spezifische Offenheit der Protokolle entspricht: Zwar verfügen die Netzwerkprotokolle über einige rhizomatische Eigenschaften (sie verbinden jeden Punkt mit jedem anderen, sie operieren ohne Zentrum und fixe Grenzen), doch haben bspw. schon Deleuze/Guattari mit ihrer Analytik des Rhizoms immer auch eine gewisse Abneigung gegenüber der binären Logik kybernetischer Maschinen geäußert, da diese im Kern eine Logik des Baumes darstellen würde. (Deleuze/Guattari 1992: 27) Deleuze/Guattari schreiben: »Es gibt baumartige Verknotungen in Rhizomen und rhizomatische Triebe in Wurzeln. Es gibt sogar despotische Formationen der Immanenz und Kanalisierung, die spezifisch für Rhizome sind« (Ebd.: 35) Eine Analyse der spezifisch verteilten Netzwerkinfrastruktur muss diese Ordnungslogik der Immanenz und Kanalisierung erfassen, denn das Internet operiert gerade an der Schnittstelle zwischen einer rhizomatischen Organisation und einer Logik der Kontrolle, an der Überblendung von fortwuchernder sozialer Kommunikation und komplexen Steuerungstechniken, wobei die modulare Softwarearchitektur mit ihren rechnerbasierten Codes in der Tendenz zu statistischen Durchschnitten in der sog. alltäglichen Kommunikation führt, und dies bezüglich der Speicherung, Übertragung und Verteilung von Daten und Informationen. Diese scheinbar esoterischen mathematischen Strukturen wandern also in die zeitgenössischen Netzwerkmedien ein, kontrollieren die Interfaces der User mit Algorithmen wie Google`s PageRank oder Facebook`s Edgerank, ganz abgesehen von eine Reihe wenig bekannter Algorithmen (Appinions, Klout, Hummingbird, PKC, Cinematch, KDP Select etc.), welche die Relation der User zu den Datenströmen modulieren.

Die Autoren Brin/Lawrence, die den sog. PageRank-Algorithmus während ihrer Studienzeit in den 1990er Jahren schrieben, hatten damit einen entscheidenden Kalkül für die Entwicklung des Internets entwickelt. Sie bezogen sich bei der Konstruktion des Algorithmus auf die Zitierweise eines Buches durch ein anderes Buch, um schließlich diesen Vorgang als eine sich verkettende Bewertung zu bestimmen, wobei ein Buch, das sehr oft zitiert wird (bspw. ein Lehrbuch), im Ranking höher erscheint als ein noch unbekanntes und eben deswegen wenig zitiertes Buch. (Vgl. Hagen 2010a: 26f.) Dementsprechend erscheinen im Internet immer diejenigen Webseiten auf den vorderen Ranking-Plätzen, die stark verlinkt sind und of course meistens dem Mainstream der Diskurse, Verkaufsangebote, Informationsdienste, Wissenssysteme und Ideologien angehören. Durch dieses spezifische Gedächtnissystem namens Internet, das wie gesagt keineswegs virtuell, sondern rein operational und potenziell funktioniert, werden somit bekannte, ja durchschnittliche Erinnerungen verstärkt und weitgehend unbekannte oder minoritäre Positionen weitgehend ausgelöscht. Je mehr Links auf eine Webpage verweisen, desto höher ist auch deren Netzwerkwert einzuschätzen. Gleichzeitig führen die User durch Setzen eines neuen oder dem Anklicken eines bestehenden Links dem Google-System permanent Content zu, was Google in der spezifischen Form von Renten valorisiert. Allerdings sollte man hinsichtlich des Verlinkens für den User gegenteilige Effekte nicht ausschließen, denn Links können Besucher auch dazu animieren eine Seite schnell zu verlassen. Überhaupt noch nicht ins Blickfeld gerückt ist die Strategie des Nicht-Verlinkens, was durchaus in der Zukunft auch für Google gefährlich sein könnte, wenn bspw. Millionen von Usern die Google-Links zu ihren Seiten einfach löschen würden. Geert Lovink schreibt: »Techno-Materialisten sagen, dass Links Maschinen füttern, die für den cybernetischen Konsum geschaffen wurden. Blog-Spam mit seinen langen Linklisten zeigt perfekt, wie die Ökonomie massenproduzierter Verlinkung funktioniert. Links sind die Grundeinheit für die Informationsökonomie, um ihre eigene Existenz zu erforschen, zu kartografieren und zu reproduzieren. Googles Imperium ist auf die Verlinkungsarbeit gegründet, die Andere in ihre Websites und Dokumente stecken.« (Lovink 2012: 26) Mittels des sog. PageRank-Algorithmus wird also die kognitive Dichte bzw. Verteilungsstruktur von Daten und Informationen im Internet durchsucht und zugleich evaluiert, um jedem Knoten einen Ranking-Wert zuzuweisen, der vor allem der Ranking-Wert des Unternehmens Google selbst ist, wobei dieser inoffiziell als die entscheidende Währung der globalen Aufmerksamkeitsökonomie gilt, eine Währung, mit der man die Online-Sichtbarkeit und im Zuge dessen vor allem die Machtpotenz von Unternehmen, Gruppen und Akteuren misst, um implizit deren Image, Geschäftsfähigkeit und Marketingpotenzial zu bewerten.3 Der PageRank-Algorithmus stellt daher eine der wichtigen determinierenden Operationen in den 24-Stunden-Realtime-Datennetzwerken dar, indem er permanent den Web-Index aktualisiert. Hierin ist die Identifizierung und Bewertung einer Webpage durch den PageRank-Algorithmus gleichbedeutend mit der Bestimmung ihres Netzwerkwerts und Netzwerk-Mehrwerts, jene Form, die Deleuze/Guattari als maschinellen Mehrwert bezeichnet haben, der im Internet durch die Transformation des Mehrwerts an Codes in einen profiträchtigen Geldstrom entsteht. Über die Codierung, i. e. ausführbare Sprache, erfolgt die Erstellung eines Diagramms, wobei der PageRank-Algorithmus die asymmetrischen Relationen zwischen zwei Knoten eines Netzwerks aufzeichnet (jeder Link verweist wie ein Pfeil in eine Richtung) und damit zugleich für einen asymmetrischen Austausch von Aufmerksamkeit, Diskursen, Wissenssystemen und Wünschen sorgt – es handelt sich hier letztendlich um ternäre Relationen, weil mit der binären Relation immer auch auf einen dritten Knoten verwiesen wird, der die Relation u. U. manipulieren und weitere Akkumulationen von Netzwerkwert in Gang setzen könnte. Google ließe sich in diesem Kontext als ein globaler Vermieter beschreiben, der den (fruchtbaren) Boden des Internet ausbeutet, ohne dass so etwas wie materielle Umzäunungen zur Sicherung des Eigentums oder die Produktion von Content (im Gegensatz zu Facebook) noch nötig wären. Die Modelle Google, Twitter und Facebook zeigen, wie die Einsparung fixer und variabler Kosten vonstatten zu gehen hat, was bei Facebook wiederum eng mit der kostenlosen und freiwilligen Partizipation der User/Konsumenten an der Contentproduktion verbunden ist, die den Aufbau und die Integration dieses Netzwerkes erst möglich macht. Man sollte diese Art der Beschäftigung allerdings nicht unbedingt als unbezahlt qualifizieren, weil man ja etwas zurückbekommt, wenn auch meistens weniger als man gibt. Hier wird der User neben seinen Jobs, die er ansonsten noch bewältigen muss, weniger ausgebeutet, als er sich vielmehr im Modus eines Nicht-Angestelltseins in einem andauernden Zustand der Hyperbeschäftigung befindet. Im Zuge der Auswertung des Big Data, egal ob die kommerzielle Datenbewirtschaftung im Kontext einer prosperierenden Wirtschaftsinformatik bei Facebook oder Twitter stattfindet, kommt es darüber hinaus zu einer kontinuierlichen statistischen Evaluation der verschiedenen Märkte, der individualisierten Serviceangebote und generell des kollektiven Wissens.Und gewiss bedarf das Internet einer soliden materiell-technologischen Infrastruktur und gerade deswegen ist der Exploitationsgrad der Arbeiter bspw. bei der Herstellung von Apple Produkten in Niedriglohnländern im asiatischen Raum nicht zu unterschätzen. Die Gliederung der Arbeit in diesen Ländern folgt der ungleichzeitigen Bewegung der Deterritorialisierung und Reterritorialisierung von Kapital und zusammengesetzten Arbeitskörpern, d. h., die frei flottierenden und billigen Arbeitskörper mit ihren gewaltigen Migrationsschüben werden in Asien nach wie vor in der Fabrik reterritorialisiert, während die Informationsmaschinen in den kapitalistischen global cities die Gefüge der Arbeit und des Dienstes über den gesamten Globus hinweg beständig einer Deterritorialisierung zuführen.

Es war Manuel Castells, der in seiner Netzwerkanalyse den elektronischen Netzwerken, die niemals so flach und horizontal organisiert sind, wie gemeinhin angenommen wird (heutzutage werden Links so gesetzt, dass man in den Suchmaschinen weit oben erscheint) – speziell den Börsennetzwerken einen sog. »space of flow« (von Geldkapital) attestiert hatte, dessen Aufzeichnung/Codierung in einem interaktiven Bezugssystem mittels dezentraler Verzweigungen und temporärer Verdichtungen geschieht. (Vgl. Castells 1996) Zur Analyse der Organisation dieser Art von Netzwerken nimmt Castells eine Dreiteilung vor: a) die materielle Ebene der technischen Infrastruktur, die unabdingbar für die Kommunikation in Echtzeit ist, b) die Entstehung hierarchischer Knotenpunkte im Netz, c) die machttechnologische Ebene der räumlichen Organisation, mit deren Hilfe die Steuerung der Geldkapitalströme gelingt. (Ebd.: 412) Marxistische Autoren wie Negri und Vercellone betonen gegenüber dem Konzept des maschinellen Mehrwerts, der auf den Begriff der Strömung rekurriert, stärker die »Enteignung der Allmende durch Miete«, was ihrer Auffassung nach eng mit dem Rente-Werden des Profits zusammenhängt. (Vgl. Marazzi 2011: 45ff.) Damit ist u. a. gemeint, dass das Regime des geistigen Eigentums, das aktuell laufend neue Strategien der Verknappung durchsetzt, um das Copyright und Patentrecht anzuwenden und das sog. geistige Eigentum weiterhin zu privatisieren, bestimmte kognitive Güter wie universell anwendbare Computersoftware, die als Resultat der Arbeit eines Kollektivs zu verstehen sind, mit künstlichen Kosten belastet, was nichts anderes heißt, als dass Medienkonzerne wie Microsoft aufgrund einer rein rechtlichen Kodifizierung für die Vermietung bzw. Zugänge zu dem von ihnen angeeigneten und erstellten Wissen Geldbeträge erheben können. Diese Form der Lizenzen, Gebühren und Abgaben sollte man laut Negri, Lohoff/Trenkle und anderen Autoren weniger als Realisierung von Mehrwert, sondern als Informationsrente begreifen, sodass man das PageRank-Diagramm als eine Art Differenzialrente innerhalb eines Sets von dynamischen Räumen beschreiben könnte, die sich überschneiden und in Multidimensionen mit Hilfe von hohen Energieströmen fortwuchern. Faktisch sind Konzerne wie Microsoft von den sog. Eigentumsrechten und deren Sanktion und Legitimierung durch den Staat abhängig und natürlich auch von ihrem eigenen Machtpotenzial, diese Rechte valorisierbar zu machen. Und es spielt in diesem Zusammenhang überhaupt keine Rolle, ob Microsoft zur Sicherung seiner Position Milliarden von Dollars zur Invention von Softwareprogrammen ausgibt, oder ob man sich diese gratis von anderen Instanzen angeeignet hat. Schließlich kostet die Reproduktion dieser Programme nur wenig, womit die einzige Barriere, um die Reproduktion zu verhindern, darin besteht, Gesetze und ihre Anwendung zu affirmieren. Würde man nun die Bestrafung einer kostenlosen Reproduktion der Programme unterlassen, so würden Microsofts Profite/Renten wie auch ihre Kapitalisierung schlichtweg kollabieren und gegen Null tendieren. Microsofts differenzielle Rente oder Profitabilität hängt also von einer bestimmten Politik des Wissens und des Rechts ab.

Schauen wir uns die digitalen Produktionsprozesse noch etwas genauer an. Es sind italienische Autoren wie Negri, Virno oder Marazzi, die behaupten, dass im Rahmen des sog. kognitiven Kapitalismus menschliche Komponenten wie Körper, Affekte, Sprache und Kognition längst Teile des fixen Kapitals bzw. Teile einer Maschinerie geworden seien, die nun so etwas wie die Materialisierung des Wissens darstelle, eine durch und durch produktive materielle Grammatik, die das Kapital als ein soziales Verhältnis (industrielles Management, wissenschaftliche Forschung und Wissenssysteme) permanent zu interiorisieren versucht, um damit beständig neue Quellen des Profits oder der Rente zu erschließen. (Vgl. Marazzi 2012: 75ff.) Es existiert eine lebendige, maschinelle Dimension des Wissens, die sich außerhalb des in den industriellen Maschinen fixierten toten Kapitals befindet, und insofern es sich um eine kollektive Dimension des maschinellen Wissens handelt, können sich Autoren wie Negri oder Marazzi durchaus auf das von Marx in den Grundrissen beschriebene Konzept des General Intellect berufen. Die Produktivität des General Intellect hatte Marx nicht nur in der Vergegenständlichung der Forschung und des Wissens in den industriellen Maschinerien sowie innerhalb der kooperativen Dimension der Betriebsorganisation ausgemacht, sondern auch in der Intelligenz der arbeitenden Massen selbst, die die Herstellung der Arbeitsorganisation qua autonomer Kooperation kongenial als eine soziale Fabrik betreiben, und diese eben nicht als Assoziation eines organischen Ganzen, sondern als Ensembles von Singularitäten (Negri). Gleichzeitig muss aber mit Marazzi oder Virno betont werden, dass kognitive und informationelle Arbeit – Operationen vor oder neben der Maschine, um Information zu generieren – heute wichtige Quellen der Extraktion des Mehrwerts außerhalb der traditionellen Fabriken bilden. Diese Art der Extraktion des Mehrwerts findet stärker denn je in der Zirkulation selbst statt, d. h., innerhalb der semiotisch/medialen Netzwerkinfrastrukturen und den immer auch materiell fundierten Diskurssystemen des Wissens, bspw. mittels des sog. crowdsourcing im Internet, der Erfassung einer großen Menge von Akteuren und deren Datenproduktion, um damit das Capturing von Mehrwert zu betreiben, womit der moderne Biokapitalismus Mehrwert längst nicht mehr allein aus als Arbeitsmittel funktionierenden Körpern extrahiert, sondern aus einem maschinellen Konglomerat von Körper, Sprache, Affekte und Denken, der Exterritorialisierung der Gehirne, mit den spezifischen Ankopplungen an das fixe Kapital. (Vgl. Virno 2008: 150f.) Dabei ist von verschiedenen Faktoren auszugehen, die für die Auslagerung der Mehrwertproduktion aus dem Bereich der industriellen Produktion in die topographischen Räume der Zirkulation oder Distribution eine ganz gewichtige Rolle spielen: Outsourcing der Dienstleistungen, Umwandlung hierarchisierter betrieblicher Strukturen in multifunktionale (horizontale) Einheiten, die durch Informationsnetze miteinander verbunden sind, Outsourcing von ganzen Unternehmenssegmenten, externe Unternehmensberatung durch selbständige Arbeitskraftunternehmer und schließlich die Verwandlung der Konsumenten in Pseudo-Produzenten, die in den sozialen Netzwerken freiwillig, bisweilen auch mit Euphorie bzw. im Zuge der Exploitation von Emotionen für die Medienkonzerne notwendige Tätigkeiten verrichten.4 Die Unternehmen generieren ihre Profite also längst nicht mehr nur auf der Ebene der Produktion, sondern gerade auch über die Regulation und Kontrolle der Distributionswege, der Zirkulation und des Web 2.0, wobei es meistens unsichtbar bleibt, wie diese Art der kostenlosen Dienstleistungen im Zuge des begierigen und begehrlichen Spiels um die Interaktionen der User untereinander von Unternehmen wie Amazon, Facebook, Google etc. valorisiert wird. »Die new frontier, die sich dem kapitalistischen Verwertungsprozess mit den Innovationen dieser Art der New Economy eröffnet, ist die Marginalisierung der Lohnarbeit und die Verwertung einer besonderen Form ›freier Arbeit‹, nämlich einer weder bezahlten noch vorgegebenen, aber dennoch kontrollierten Arbeit der Anwender«, schreibt Tiziana Terranova.5 Und für Christian Marazzi und andere Postoperaisten bilden Faktoren wie Flexibilisierung innerhalb netzwerk-konstituierter Unternehmensformen, Prekarisierung der Arbeit und diskontinuierliche Beschäftigungsverhältnisse, Lohnsenkung und freiwillige Dienstleistung die entscheidenden Ressourcen der neuen Mehrwertproduktion – sie stellen wichtige Quellen der Finanzialisierung und der Kapitalisierung dar. Marazzi fasst diese Prozesse folgendermaßen zusammen: »Diese Dispositive stehen für die neue organische Zusammensetzung des Kapitals, das heißt für die Beziehung zwischen einem verteiltem, in der Gesellschaft zerstreuten konstanten Kapital (als einer Gesamtheit ›linguistischer Maschinen‹), und einem variablen Kapital, das deterritorialisiert und entdefiniert ist […].« (Marazzi 2011: 56) Und es gilt an dieser Stelle anzumerken, dass mit dem Internet eine unaufhörliche Spannung zwischen endlicher Zeit (des Individuums) und unendlichem digitalem Raum eröffnet wird, die heute bei vielen Individuen zumindest die Tendenz zur Depression oder wahlweise ADHS hervorbringt, indem man sie mit einem Überangebot an Informationen sowohl in physischer als auch in psychischer Hinsicht geradezu immobilisiert oder hyper-mobilisiert, d. h., die Steigerung des Lebenstempos führt in der Tendenz zur Verknappung der individuellen Zeitressourcen ohne dass man jedoch den physikalischen Raum noch durchqueren muss, so dass man gerade intensiver in die Abhängigkeit von Suchmaschinen und deren Algorithmen gerät, die in sog. Echtzeit Entscheidungen treffen, indem sie vorhandene Informationen testen und Möglichkeiten anzeigen. Bifo Berardi hat dies in seinem Buch »After the future« prägnant beschrieben, wenn er vom ›paradox of the decider‹ spricht, einem Entscheidungsträger, der keine Zeit mehr besitzt, um die zur Verfügung stehenden informationen zu verstehen und zu bewerten, sodass er sich ganz auf den Automaten verlassen muss, um nicht in Verzug zu geraten. (Vgl. Berardi 2011)

Es sei weiter hinzugefügt, dass die Sprache des Postfordismus längst nicht nur auf einer Sprache der Kreativität und Virtuosität beruht, wie Negri/Hardt mit ihrer Überbetonung des kreativen und produktiven Moments der Arbeit innerhalb des zusammengesetzten Körpers der Multitude annehmen, sondern sie inkludiert vor allem eine formallogische/objektorientierte Sprache, die zuallererst logische und logistische Instruktionen, Befehle und Direktiven beinhaltet. Sie liefert die wichtigen Codes für die Daten- und Informationsströme, und der informatorisch maschinelle Mehrwert entsteht durch die Transformation des Mehrwerts der Codes in den Mehrwert von Metadatenströmungen und darüber hinaus in Geldströmungen. Somit generieren die decodierten Codes der Wissenschaften einen maschinellen Mehrwert, der nicht unmittelbar von Wissenschaft und Technik selbst abhängig ist, sondern in erster Linie von den informatorischen Kapitalmaschinerien, die den tendenziell fallenden menschlichen Mehrwert kompensieren, um eine Gesamtheit des Mehrwerts der Strömungen herzustellen.

Wenn Gilbert Simondon die industrielle Maschine als ein Relais definiert, das zwischen den beiden Strömen der Energie und der Information vermittelt (vgl. Virno 2008: 171ff.), so könnte man, Elektrizität natürlich vorausgesetzt, die vernetzten Turingmaschinen als Relaisstationen zwischen mindestens drei Komponenten beschreiben: Sie bestehen a) aus Strömen der Information, b) Strömen der Metadaten und c) dem maschinellen Code. Dieser Struktur entsprechen Prozesse, in denen die Algorithmen als logische Form oder Standards der Information zum einen Information in Information übersetzen, zum anderen die Akkumulation von Informationen (über Informationen) ermöglichen, womit sog. Metadaten generiert und extrahiert werden, die zugleich das Resultat einer ganz spezifischen Netzwerklogik sind, indem sie sozusagen den Aufbau der Netzwerke kartographieren und mitstrukturieren. So scheint es bisweilen das Ausmaß sowohl der Extraktion als auch der Generierung von Metadaten zu sein, die die neue Verfasstheit der digitalen Ökonomie kennzeichnet, womit man diese Organisation der Metadatenakkumulation als industrielle Revolution der Daten und der Information bezeichnen könnte; es handelt sich hier um eine spezifische Bifurkation des maschinellen Phylums, das die Informationsmaschinerie als ein meta-informationelles Relais vorführt, über das Akkumulation, Speicherung, Transport, Verwaltung und schließlich der Handel von Informationen und Metadaten heute funktioniert. (Vgl. Pasquinelli 2011) In diesem Sinne wird es auch erforderlich, dass digitale Arbeiter die kybernetischen Apparaturen permanent mit Paketen von Daten und Informationen füttern. Im Speziellen ist es die Valorisierung der »Ressource« Akkumulation der Information (Metadaten), die ihrerseits ganz entscheidend Faktoren wie Organisation, Marketing und Programmplanung der Unternehmen beeinflussen und verbessern. Die von Alexander Galloway angesprochene antihermeneutische Tendenz der Netzwerke im Rahmen einer Protokollarchitektur der Kontrolle zeigt darüber hinaus an, dass Metadaten nicht mehr im überlieferten kulturtechnischen Sinne von Subjekten gelesen, sondern maschinell-kybernetisch geteilt, gescannt, gefiltert, kombiniert und interpoliert werden. Metadaten dienen der Strategemisierung und Verbesserung der Leistungen der maschinistischen Intelligenz selbst, während die Akkumulation der Metadaten die Extraktion von Informationsrente und/oder Mehrwert auf jedem möglichen Level ermöglicht, und dies eben mit Hilfe des Einsatzes von Softwareprogrammen, Wissensmanagement, Produktionsdesign und Interface Usability, Mobilität und Logistik. Matteo Pasquinelli zufolge repräsentieren die Logik und Logistik der Metadaten ein »Maß« der Information, mit dem die Kalkulation von sozialen Dimensionen und deren Bewertung erst möglich wird. (Ebd.)

Wenn die Verflüssigung der standardisierten, statischen Archive in Ströme von Daten und Informationen eine der wesentlichen Leistungen des Internets ist, so bedürfen die Ströme, wie wir in der Diskussion um den Maschinenbegriff bei Deleuze/Guattari gesehen haben, immer auch der Codierung. Dabei sind die algorithmischen Standards, Protokolle und Skripte als vermittelnde Instanzen zwischen der strömenden Mehrwertproduktion und der technischen Infrastruktur zu verstehen. Der Term digitaler Code enthält im Wesentlichen drei Komponenten: a) die binären Bits, die einen analogen Input in 1 und 0 Impulse enkodieren, b) die diversen objektorientierten Computersprachen, c) das Skript/Textquelle der Softwareprogramme in der logischen Form des Algorithmus. (Ebd.) Technische Systeme werden durch generative Regeln konstituiert, oder anders gesagt, Algorithmen, d.h. generative Regeln, die die technischen Systeme steuern, bildet den Kern der technologischen Objekte. Algorithmen stellen die Codes bereit, mit denen heute Waren und Kapital generiert und gemessen werden. [Dabei entstand die Informatik entlang der Problematik um das mathematisch Unendliche. In diesem Zusammenhang ist die Logik der Zugehörigkeit und Inklusion, wie sie etwa in Badious Ontologie vorgenommen wird, für Alexander Galloway identisch mit der Logik der Mitgliedschaft und der Vererbung, welche seiner Ansicht nach die aktuellen objektorientierten Computersprachen strukturiert. Für Badiou gibt es immer mehr Möglichkeiten, die Elemente einer Menge in Untermengen zu verteilen, als es Ausgangselemente in der Menge gegeben hat. Der Überschuss der Untermengen über die Terme (Inklusion) würde demnach auf den Term der Vererbung in den Computersprachen (Java) verweisen. Zugehörigkeit verweist auf eine gegebene Mengals Totalität, in der die Elemente vollständig integriert sind. Allerdings haben Badiou and Meillassoux nie voll auf die Komputation oder den kalkulatorischen Aspekt der Komputation gesetzt, denn ihr Bezug auf die Mengentheorie impliziert die post-cantorianischen Annahme, dass bestimmte mathematische Problematiken weder entschieden noch kalkuliert werden können. Die Wahl zwischen der Zugehörigkeit und Inklusion ist zufällig und fällt für Badiou damit in den Bereich Konstitution des (politischen) Subjekts, während für Meillassoux damit sich alles und nichts auf der Ebene der Welt an sich ereignen kann.] Diese Sprachen beeinflussen die Logik der Identifizierung, der Erfassung und Vermittlung von Objekten und Körpern. Java und andere Computersprachen dürfen somit durchaus als konstitutive Tools der gegenwärtigen postindustriellen Netzwerkinfrastruktur gelten. Dabei gilt es zu bedenken, dass die postfordistische Ökonomie nicht nur durch Software (symbolische Maschinen als Teil des fixen Kapitals) gesteuert wird, in vielen Fällen dient sie der Messung, welche schließlich die Extraktion von Mehrwert sichert. Postindustrielle Konzerne wie Google nutzen bspw. die Graphentheorie für ihre monetäre Valorisation, während Monsanto lebende Organismen mit der Prozessierung von Information in bioinformatische Gensequenzen übersetzt; Equifax betreibt sein Leverage in der Sphäre der Konsumentenkredite mit komplexen Algorithmen, um Wert aus der Bewirtschaftung von Datenbänken zu extrahieren. Fast jeder Aspekt der postindustriellen kapitalistsichen Produktion muss heute also die entsprechenden Adaptionen, Erfordernisse und Wechselhaftigkeiten der Softwareindustrie berücksichtigen (algorithmisches Trading; Bioinformatik etc.), ihre mathematischen Objekte und ihre binären Projektionen; es ist exakt die differenzielle Relation zwischen der Software als Code und den deterritoralisierten Strömungen der Wissenschaft und des Wissens, welche die Transformation eines Mehrwerts an Code in einen Mehrwert an Strömung ausdrückt.

Software basiert auf symbolischen Tokens, die über mathematische Funktionen (Addition, Subtraktion, true-false logic) und logische Kontrollstrukturen (»wenn x dann y«) kombiniert werden. Software ist Mathematik. Kant argumentierte, dass alle mathematischen Urteile synthetisch seien, während sie nach wie vor apriorisch blieben. Wenn man »3 plus 5 ist 8« sagt, hat man mit Achtheit etwas hinzugefügt, das in »3 plus 5« nicht gegeben war. Es geht aber längst nicht mehr nur um das mathematische Urteil allein, sondern es geht vor allem darum, zu untersuchen, was es heißt, wenn die Mathematik heute industrialisiert, monetarisiert und valorisiert wird. Die Infrastruktur der heutigen kapitalistischen Produktionsweise, der man eine ganz spezifische Verknüpfung von fixem und variablem Kapital injiziert, ist ohne die Prävalenz der Software als Teil des fixen Kapitals nicht mehr zu denken, sodass in den meisten Fällen die symbolischen Maschinen in den Produktionsprozessen längst deren technologischer Kern bilden. Der digitale Automat ist elektronisch-komputational, er komprimiert die Möglichkeit zur Virtualisierung, Simulation, Abstraktion, Feedback und andere Prozesse, und seine Funktionalität generiert er über den Algorithmus, der eine eigenständige Existenz gegenüber seinen diversen Implementierungen besitzt, und dies wiederum als Teil von Gefügen, deren andere Teile Hardware, Daten, Datenstrukturen oder -bänke, Körper und Verhaltensweisen sind. Wenn Algorithmen weder ein homogenes Set von Techniken noch die Exekutoren einer automatisierten Kontrolle und Ordnung darstelen, dann ist davon auszugehen, dass eine potenziell unendliche Menge von Daten ständig mit algorithmischen Prozessen interferiert, indem sie eine bestimmte Quantität von Information im Zuge der Verwertung enkodieren, obgleich Algorithmen als eine Form des fixen Kapitals nicht an sich verwertbar sind, sondern der Monetarisierung ausgesetzt sein müssen. Der digitale Automat entfaltet sich in Netzwerken, die aus nervlichen und elektronischen Verbindungen besteht, in welche die User als quasi-automatische Relaisstationen inmitten eines richtungslosen Stroms von Daten und Informationen eingebunden sind. Und mit Hilfe solcher Instrumentarien wie der der Algorithmen ist man heute in der Lage, komplexe Probleme qua Splitting, Stückelung und Verteilung in einfache Probleme zu übersetzen, sodass fast jedermann diese Art von Problemen zu lösen vermag. An dieser Stelle könnte man dann anmerken, dass sich Adornos Feststellung bezüglich der Ideologisierung von Kompetenz und Leistung im Kapitalismus vollkommen bestätigt hat. Er schreibt. »Es ist eine armselige Ideologie, daß zur Verwaltung eines Trusts unter den gegenwärtigen Bedingungen irgend mehr Intelligenz, Erfahrung, selbst Vorbildung gehört als dazu, einen Manometer abzulesen.« (Adorno 2012: 146)

Kommen wir in diesem Zusammenhang noch einmal kurz auf die digitalen Technologien der Finanzmärkte zu sprechen. Im Kontext der globalen »Echtzeitökonomie« treibt und flieht heute auf Grundlage der Funktionsweisen der Telekommunikations-, Informations- und Unterhaltungsindustrien die Kapitalverwertung in die Zukunft. Die Instantaneität der Datenübertragung – minimale Zeitspannen von der Order bis zum Backend und deren Bestätigung zurück zum Kunden – hat nur noch die Lichtgeschwindigkeit als Grenze, womit die Zeit noch jenseits der operativen Sekundenaktivität selbst zu einem außerordentlich wichtigen Parameter der Zahlungen wird, Zeit, die man permanent zu berechnen, justieren und zu korrigieren hat, weil die Händlerentscheidung vom frühen Morgen spätestens am Mittag schon wieder Schnee von gestern ist – insgesamt folgt man mit seinen Entscheidungen den flüssigen maschinellen Bewegungen der Algorithmen, um jederzeit die Möglichkeit des rechtzeitigen Geldanschlusses für Banken und Finanzinstitutionen zu gewährleisten. Echtzeit ist jene (strömende) Zeit, die durch den Gebrauch der digitalen Übertragungsgeschwindigkeit in infinitesimaler Annäherung an die Lichtgeschwindigkeit die sofortige Verfügung über Datenpakete, Informationen und Metadaten auf allen Börsenplätzen und in allen Zeitzonen weltweit ermöglichen soll. Die Signale des Internets werden also in Lichtgeschwindigkeit übertragen, aber selbst diese kann im heutigen Computerhandel noch zu langsam werden, sodass z. B. eine Transaktion, die ein Broker in Frankfurt tätigt, mit höherer Wahrscheinlichkeit mit einem Händler in London als mit einem Händler in New York abgeschlossen wird, weil das Signal von Frankfurt aus London früher als New York erreicht. Sender, Kanal und Empfänger sind dabei Teile einer (materiellen) Netzwerktechnologie, die diese extrem beschleunigende Zeitkonstruktion in einem digitalen Übertragungsraum weltweit aufzuspannen hilft, sodass tatsächlich alle Informations-, Metadaten- und Geldkapitalströme (in einem glatten Raum oder einer Topologie der Oberfläche) gleichzeitig zu sein scheinen, womit Differenziale, Asymmetrien und Codierungen der Geldkapitalzirkulation zu Millisekunden zusammenschmelzen. Die auf globaler Ebene deterritorialisierten Geldkapitalströme sitzen also dem Echtzeitregime der Telekommunikations-, Informationsindustrien und deren Managementtechniken auf. (Vgl. Reichert 2009: 49f.) Und nur mühsam wird die rasante Dromologie, die Fluidität und Flexibilität dieser Geldkapitalströme durch Regeln und Gesetze der Kreditvergabe, durch nationale und transnationale Politiken und durch die Politik der Notenbanken codiert bzw. reterritorialisiert. Die getaktete Zeit im Börsenhandel bleibt dabei von der Leistungskapazität der jeweils eingesetzten Computersysteme abhängig, wobei dominante Gruppen von Spekulanten heutzutage ihre Serverfarmen in unmittelbarer Nähe der Börsen zu platzieren versuchen, um noch zeitintensiver ihre Transaktionen über die schnellsten Kabelverbindungen ausführen zu können – und damit wird letztendlich die sog. Latenzzeit zwischen der Generierung einer Order und deren Verarbeitung an der Börse nur noch von physikalischen Konstanten und einer topologischen Geometrie begrenzt. Grzebeta schreibt: »Auf algorithmischen Handel spezialisierte Banken können bei Bedarf über 100 Orders pro Sekunde generieren und diese unmittelbar an die Börse leiten. Eine Order braucht derzeit, je nach Ort und Börse, zwischen 5 und 150 Millisekunden, um vom Teilnehmersystem zur Börse gesendet und dort im Börsensystem verarbeitet zu werden.«6 Wenn Derrida den heutigen Kommunikationstechnologien »die Essenz des Geldes selbst als Zeit« zuschreibt (vgl. Derrida 1999), so unterliegen die monetären Transaktionen auf Grundlage der zunehmenden Konvergenz der Telekommunikations- und Informationsindustrien einer äußersten Geschwindigkeit, sodass selbst das Echtzeitregime der Börse die Funktion eines Second-Order-Operators bezüglich der Verkettung von Zahlungen übernimmt, was aber durchaus zu »Kausalitätsvazillationen« (Otto Rössler) führen kann, einer Art Verrauschtheit der Zeit, und dies als Resultat der sukzessiv und simultan verlaufenden Kapitalisierungen, ihrer Instantaneität. Ein Echtzeitregime und seine Feld- und Zeitoperatoren kann man auch nur schwerlich über die rigide Organisation einer Antwortzeit bremsen (welche ein ganz spezifisches Management der zeitlichen Intervalle zwischen den verschiedenen Transaktionen beinhalten müsste), da deren Geschwindigkeit stets in bestimmte Zeit-Differenziale eingebunden bleibt. Echtzeit löst tatsächlich die statistischen und statischen Archive auf und schiebt unaufhörlich die Zeit als Strom voran. Und schließlich ist es die Hardware, die jede Software zur Berücksichtigung der Zeit zwingt.

Nun suggerieren die Modi der Simultaneität, denen sich das Echtzeitregime approximativ annähert, dass es jedem Finanzakteur möglich sei, innerhalb des 24-Stunden-Online-Business mit dem digitalisierten Zugriff auf alle weltweit verfügbaren Kursnotierungen und Kursbewegungen ortsunabhängig Transaktionen mit Finanzderivaten jederzeit durchführen zu können, womit der Akteur einerseits in einen extrem flexiblen Zeithorizont integriert wird, andererseits die Preis- und Kursbewegungen die absolute Vorherrschaft des Hier und Jetzt einfordern, das Paradox einer ewigen Aktualität, die von den technologischen und ökonomischen Dispositiven nur noch gesiebt und performativ gedeutet werden muss. Das Jetzt, die Gleichzeitigkeit der Verfügbarkeit aller kapitalistischen Börsengeschäfte würde damit zum alles beherrschenden, zeitbezogenen Imperativ, der sich technologisch ins Werk setzt, allerdings nicht verhehlen kann, dass a) weiterhin Marktbarrieren und -schranken existieren, wenn auch die Zahl der Day- und Hobbytrader heutzutage enorm zugenommen hat, und b) das abstrakte, ungleichgewichtige und dynamische Zeitregime des Kapitals bzw. die Kapitalisierung diesen spezifischen Modus der Gleichzeitigkeit steuert, moduliert & modifiziert und in der-letzten-Instanz determiniert, sodass leicht übersehen wird, dass das kapitalistisches Zeitmanagement immer den Maßen der Kapitalisierung untersteht, womit gerade Zeitpakete erzeugt werden, mit denen in der differenziellen Konkurrenz der Kapitale wenn auch noch so minimal ungleichzeitig operiert wird. Obgleich das operative Zeitkonzept der Einzelkapitale im Rahmen der Produktion, des Managements, des Planungshorizonts und der doppelten Buchführung Zeit (als Fluss-, Mess-, Codierungs- und Steuergröße) vor allem als die Dimension kennt, die linear in die Zukunft verläuft und dies scheinbar ohne jegliche Brüche, Verschiebungen und Setzungen, bleibt diese Art der Homogenität des linearen Zeitflusses stets Teil der differenziellen Akkumulation bzw. einer nicht-linearen, ungleichzeitigen und abstrakten Zeit der pluralen Kapitale. Nicht zuletzt deswegen entsteht auch jene Welt des globalisierten Weltwirtschaftskrieges, deren verschiedene Echtzeitregime nur scheinbar in einer ökonomisierten Weltzeit konvergieren, wobei diese Zeit, die sich u. a. als Aktualität der Börsen artikuliert, jedoch nicht an sich gegeben ist, sondern eben gerade von transnationalen Kapital- und Mediendispositiven und deren Matheme permanent performativ erzeugt wird. Und generell wäre zu sagen: Geld ist Zeit, und weil diese selbst an sich keinen Maßstab hat, bleiben alle Kreditbewegungen und monetären Geschäfte risikobehaftet und als Erwartung an Gewinne in der Zukunft, auf die trotz der noch nicht vorhandenen Werte in der Gegenwart jetzt schon zugegriffen wird, systemisch unsicher. Und es gilt zu bedenken, dass Finanzmärkte hinsichtlich ihrer Zeitlichkeit im Dazwischen von objektivistischem Echtzeitregime und operationalisierbarer Kapital-Zeit aufgespannt sind.7

2 Vgl Hagen 2010a. Michel Serres hat schon im Jahr 1964 ein netzförmiges Diagramm zur Darstellung von Kommunikation vorgeschlagen, um dem, wie er sagt, Reduktionismus der Dialektik zu entkommen, die es seiner Auffassung nach nur ermögliche, jeweils zwei Punkte zueinander in Beziehung zu setzen; allerdings verglich Serres damals Netzwerke noch mit dem Format des Schachbretts (auf dem Schachbrett gibt es Figuren mit demselben Potenzial, deren aktuelle Fähigkeiten jedoch von den Stellungen gegenüber anderen Figuren abhängig sind, und solche Figuren mit definitionsgemäß unterschiedlichen Potenzialen, die allerdings auch auf Stellungen und Verteilungen anderer Figuren bezogen sind). Serres` Diagramm besteht »aus einer Mehrzahl von Punkten (Gipfeln), die untereinander durch eine Mehrzahl von Verzweigungen (Wegen) verbunden sind (..) Dabei ist per definitionem kein Punkt gegenüber einem anderen privilegiert, und keiner ist einseitig einem anderen untergeordnet.« (Serres 1991: 9)

3 Der bekannte Internetforscher Barabási hat den Verknüpfungsgrad verschiedener Webseiten untereinander untersucht: Während 90 % der Seiten weniger als zehn Verknüpfungen aufweisen, sind die oberen 3 % millionenfach vernetzt. Damit erweist sich die Ideologie der Vielfalt und Egalität des Internet als eine (objektive) Illusion. (Vgl. Barabási 2004: 55ff.) Die führenden Dienste im Web, die einen Großteil aller Zugriffe auf sich vereinen, waren zum Zeitpunkt 20.04.10: 1. google.com; 2. facebook.com; 3.youtube.com; 4. yahoo.com; 5. live.com (Microsoft); 6. wikipedia.org.

4Die kognitive Arbeit – Wissen, Affekt, Sprache und Imagination – konzentriert sich in räumlicher Hinsicht nach wie vor in den kapitalistischen Metropolen bzw. global cities, die selbst hochmodernen »Fabriken« gleichen, in denen sich Arbeitszeit und Lebenszeit komplex ineinander verschränken; es handelt sich multidimensionale Räume, die von den vielfältigsten Kommunikations- und Informationsströmen unter der Dominanz der finanziellen Kapitale durchquert werden, wobei man in und mit diesen nichtfiguralen Topologien die kognitive Arbeit vor allem danach bewertet, in welche Ströme der Kommunikation bzw. in welche Organisationen und Institutionen der zu leistende Dienst eingespeist wird.

5Tiziana Terranova zitiert n. Marazzi 2011: 53. Nun sind es gerade die erfolgreichen Web 2.0 Plattformen, die die Verteilungsprozesse von Metadaten besonders effizient bewirtschaften, während die User gleichzeitig in einem »kommunikologisch« verschalteten Nirwana wandeln und delirieren, wobei sie, anstatt etwa neue Ideen zu publizieren, im Zuge eines sozial akzeptierten Narzissmus und Zynismus meistens nur Belanglosigkeiten austauschen, die jedoch für die Plattformen selbst durchaus den Charakter von Informationen besitzen, die die Unternehmen folgerichtig sehr eifrig in valorisierbare und valorisierte Massenbedürfnisse verwandeln, um diese an die User zurückzuschicken. (Man nehme z. B. die Buchempfehlungen bei Amazon, die nicht über Prozesse der Signifikation oder Bedeutung funktionieren, sondern durch eine asignifikante Semiotik. Die Art und Weise wie hier Bücher ausgewählt werden, die den Kunden interessieren könnten, basiert rein auf Algorithmen, welche jeweils Vorschläge auf der Basis der eigenen Einkäufe und denen anderer Kunden kalkulieren.) Weil damit aber gerade mit Metadaten marktstrategisch rück-kommuniziert wird, was vorher (bewusst oder unbewusst) von den Usern als Information mitgeteilt wurde, entsteht eine Art positiver Rückkopplung, die eine Konzentration und Organisation von Kommunikationen und Interpenetrationen sowie deren Valorisierung beinhaltet, aus der sich ständig weitere Informationen und Metadaten extrahieren lassen. Gerade weil die Web 2.0 – Unternehmen die Prozesse der Selbstregulation der User durch deren Bewirtschaftung von immensen Selbstdarstellungspotenzialen qua demografisierter Nutzerprofile wie selbstverständlich voraussetzen, braucht man als äußeren Eingriff tatsächlich nur Benutzeroberflächen/Interfaces zur Verfügung zu stellen, wobei Features wie Like-Buttons, die auf rein assoziativer Basis funktionieren, die Affekte, Wünsche und ddas Wissen der User kapitalisieren – und das alles geschieht erstaunlicherweise auf freiwilliger Basis, wenn Subjektivitäten sich wie gasförmige Elemente ausdehnen oder kontrahieren, sich überlappen, überblenden und zeitlich strecken. Wir haben es hier noch viel stärker mit Prozessen der Desubjektivierung zu tun, weil das Wissen der User ständig an den sog. Back-End Bereich der Unternehmen weitergereicht wird, wo die Dividuen als Datenaggregate erscheinen und in eine Datenmasse transformiert werden, um mittels modulierender Evaluationen und Datenbankabfragen ihre Identifizierung zu erfahren. Den auf die Präsentationsschicht orientierten Usern bleibt sowohl der Zugang zur logischen Schicht, die alle Verarbeitungsprogramme und die Anwendungslogik integriert, verwehrt, wie eben auch die Einsicht in die Prozesse der Datenverarbeitung im Back-End Bereich.

Man schwimmt geradezu wie ein Klangpartikel in einer 24/7-Ökonomie, deren selbst gebastelte oder gesampelte Inseln Tweets sind, die kommen wie sie vergehen, wobei man die schweren Informationen auf das Festland auslagert, denn es macht einfach keinen Sinn mehr, Informationen offline auf den eigenen Geräten zu speichern und deshalb werden sie ganz ausgelagert und ihrer Verwaltung nehmen sich externe Institutionen an.Ständig fragt die Netzgemeinde kollektiv nach den besten Tweets oder den am schnellsten upgedateten Blogs, sie sucht förmlich nach hochaktualisierten Nachrichtenseiten, wobei die treibende Technologie hinter den meisten Applikationen die RSS-Feeds sind, die at once Updates von allem, was irgendwo im Netz generiert wird, zur Verfügung stellen. Und es ist und bleibt natürlich das Mobiltelefon, das den fluiden Zusammenhang von Computer, Netzwerk, Video und Audio ermöglicht, eine an den Körper geheftete Miniaturisierung der Hardware. Es geht in der Analyse dieser kybernetischen Kopplungen aber nicht allein darum zu zeigen, dass die Herstellung von Motivation, die in kontinuierlicher Produktivität des Users resultiert, nur ein weiteres Motiv der neuen Machttechniken ist (»Express Yourself! Output some data! It is how, distributed control functions best.« Galloway/Thacker 2007: 41.), sondern auch darzustellen, wie die modularen Softwarearchitekturen des Web 2.0 ganz wesentlich eine monetäre Logik bedienen, die auf der Auswertung der Informationsproduktion der User basiert. Es geht um Informationen, die in kybernetischen Feedbackschleifen prozessiert werden, um so erst als Parameter in die monetäre Berechnung einfließen zu können. Mittels ganz spezifischer Softwareprogramme analysiert man die User und ihre Handlungen, mit denen sie individuelle bzw. dividuelle Informationsprofile anfertigen, um ihre spezifischen Vorlieben, Wünsche und Präferenzen zu artikulieren. Dabei nimmt man einen permanenten digitalisierten Abgleich der Benutzerprofile von Usern vor, um davon ausgehend Vorschläge für den Konsum von Waren zu errechnen, die meist den jeweils statistisch erfassten, d. h., den durchschnittlichen bzw. normalverteilten Präferenz- und Geschmacksmustern der Konsumenten entsprechen. Und so dient der Algorithmus der Codierung eines spezifischen Selektionsmechanismus der Konsumtion.

6Grzebeta zitiert n. Reichert 2009: 70.

7An den Börsen beobachten Aktanten Zahlungen und Preisbewegungen und operieren auf der Basis dieser Beobachtungen (Beobachtungen von Beobachtungen), wobei sich die finanziellen Operationen (Operabilität generiert immer auch Nichtoperabilität) über Interfaces und Intrafaces vollziehen, die im digitalen Medium derart ineinander verschachtelt sind, dass sich andauernd Übersetzungsprobleme und dynamische Ungleichgewichte ergeben. (Luhmann war gerade davon beeindruckt, dass der Bildschirm das einzige Interface ist, das uns mit der Tiefe der Rechner und ihrer Netzwerke verknüpft.) Und wenn historische Formationen, die von Sichtbarem und Sagbarem durchkreuzt werden, heterogen und sich wechselseitig voraussetzend bleiben, dann sind Medien selbst von einem Riss in-formiert, dem Un-Ort des Medialen, der immer auch der Un-Ort des Politischen ist. In diesem Kontext wären Maschinen als Black-Boxes zu definieren, deren Funktionen der Übermittlung von Inputs und Outputs dienen. Computer, Codes, Datenbanken und Protokoll-Interfaces sind Elemente dieser Funktionen, die man in kybernetische Regelkreise einschleift, wobei Outputs derart auf Inputs zurückgekoppelt sind, dass die Inputs ständig neu selektiert werden – Inputs, zu denen, was gerne übersehen wird, eine Vielzahl ökonomischer, sozialer, juristischer, kultureller Funktionen gehören, wie eben auch zu den Outputs. Dabei stellen Preise unter der Voraussetzung, dass jede Zahlung einer Preisfeststellung entspricht, Indikatoren oder Informationen dar, die sozusagen Rückkopplungen über die Funktionsweisen der Börsenmärkte liefern, um damit wiederum auf Preise wirken zu können, womit Wirkungen stets Wirkungen erzeugen; jeder Output des Systems ist ein Input und jeder Input ein Output, und dies in einem beschleunigt schwingenden und per se instabilen Finanztransaktionssystem.

Die Instrumentenmetapher des Barometers steht in den Börsendiskursen seit dem 19. Jahrhundert (anders als das Thermometer, das in der Kybernetik die Steuerung gegenwartsbezogener Zustandsgrößen anzeigt) für die Prognostizierbarkeit der Aktienkurse. Als technisches Bild der Kontrollierbarkeit soll das Barometer Wellenbewegungen der unsichtbaren Finanzgeldströme dokumentieren, die millisekündlichen Fluktuationen an den Echtzeitmärkten. Gleichzeitig gelten Diagramme, Charts und Kurven bis heute als Sinn- und Leitbilder oder als performative Darstellungsformen der Börsenlagen. Und als Verfahren der Zukunftsantizipation treiben die diversen Modelle der Chartanalyse die Spekulation voran. Obgleich die visuelle Darstellung von Aktienkurven eine kontinuierliche Bewegung nach oben oder nach unten vortäuscht, zeigt die Chartanalytik, dass die Oberflächen, auf denen die Charting Software visualisiert wird – statistische Indikatoren, Charts und Muster – ein ganz spezifisches Prognosewissen vorführen, visuell basierte Wissenstechniken bzw. Blendwerke, mithilfe derer sich die verschiedenen Brokerteams innerhalb der Börsenmaschinerie permanent gegenseitig zu übertrumpfen oder zu unterbieten versuchen. Zahlen, Formeln, Funktionen, Charts, Tabellen und computergestützte Kalkulationen fundieren nicht nur die kalkulatorischen Praktiken an den Finanzmärkten, sondern beschleunigen und strukturieren die ökonomischen Geldkapitalströme selbst. Dabei bleiben die deterritorialisierten Geldkapitalströme in der Black Box finanzieller Transaktionsbewegungen sichtbar und unsichtbar zugleich; es geht um eine Syntax der seriellen und kontinuierlichen Reihung der Variablen, Zahlen und Symbole der Geldkapitalströme plus ihre Funktionsbeziehungen zueinander, die für die Händler als kontinuierliche Daten- und Informationsströme auf Monitoren sichtbar wird. Diese Syntax lässt aber oft vergessen, dass die Geldkapitalströme immer auch geschnitten und in diskrete Pakete aufgeteilt werden, eben an die diskret operierende Digitalität gebunden bleiben. Dabei erzeugt die Semantik der Naturalisierung und des Szientismus in den medialen Diskurssystemen und Meinungsfabriken meistens die Figur einer im Durchschnitt kontinuierlichen Aufwärtsentwicklung der Preise und Kurse, womit dann auch die Partizipation der kleinen Shareholders an den Börsen zunehmend attraktiver werden kann. Dabei bleibt der Störfall oder der Börsenskandal selbst Teil des Börsenevents, während gleichzeitig die gigantischen in Realtime bewegten Datenmengen von Finanzprodukten, Derivaten und Transaktionen die Kategorien der chronologischen Zeit und der Vermessbarkeit des Raumes sprengen. Realtime an der Börse lässt die Zeit flirren, sie wird rhythmologisch und hyperkomplex, obwohl der Rhythmus stets in den Grundtakt des 0 und 1 des binären Codes integriert bleibt.

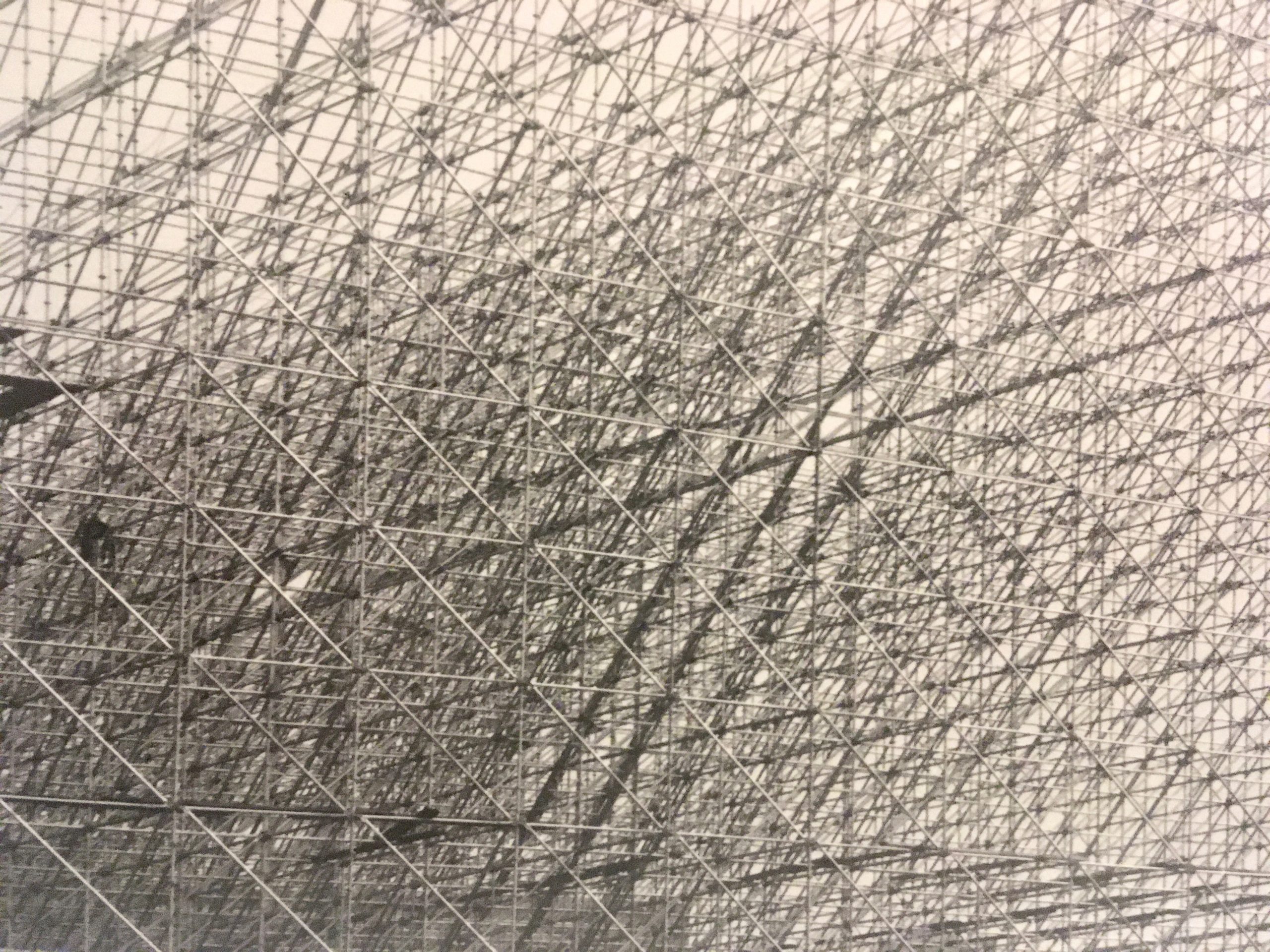

Foto: Slyvia John